AI/Classification

[논문리뷰] Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

해드위그

2025. 2. 12. 14:58

반응형

Intro

* ViT 기반으로 만들어진 백본이다.

* Swin Transformer = Vit + 1.계층적구조 + 2. shift window 라고 할 수 있다.

* window 안에서만 attention연산을 한 후, 각각 window끼리 attention 연산을 하는 형태이다.

Method

전반적인 구조는 위와 같다.

Network

- input: H x W x 3의 해상도 이미지가 입력으로 들어가고, 겹치지 않게 각각의 이미지 패치를 나눔

- stage 1: Transformer 학습을 위해 사용자가 정의한 C차원으로 매핑해줌(Linear Embedding), 여기서 2개로 구성 된 swin transformer block으로 입력되어 동일한 차원으로 출력됨 (H/4*W/4*C)

- stage 2: Patch Merging으로 (H/4*W/4*C) 의 해상도가 (H/8*W/8*2C)로 줄어듦, 2개로 구성 된 swin transformer block으로 입력되어 동일한 차원으로 출력됨.

- stage 3,4는 차원과 block 개수만 다르고 나머지는 동일함.

Patch Merging : 해상도를 줄이는 과정

- stage 1의 출력인 (H/4*W/4*C)의 차원을 2*2 그룹으로 나눔.

- 나눠진 그룹은 (H/8*W/8*C)의 차원을 가지고, 4개의 그룹들을 채널을 기준으로 concat함.]

- (H/8*W/8*4C) 병합된 차원 축소를 위해 절반인 2C로 축소함.

- 모든 스테이지에서 위 과정을 동일하게 작용함.

=> 계층적 구조를 통해 representations을 더 잘 학습할 수 있고 연산속도에도 이점이 있음.

Swin Transformer Block

Window

Swin은 window로 쪼개는 방식으로 ViT보다 연산에 이점이 있다.

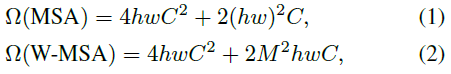

연산에 시간이 얼마나 걸리는 지 측정한 결과이다.

Swin의 경우 윈도우의 크기는 고정되어 있으므로 상수 취급이 가능하고, HW의 크기에서만 선형적으로 계산량이 증가한다.

Shift Window

- window로 나누어 각 독립적으로 self-attention을 시행

- cyclic-shifting 방식을 통해 추가적인 계산을 거의 요구하지 x

- 파티션 좌상단에서 우하단으로 진행

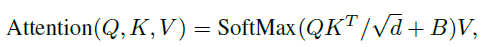

Relative Position Bias

- 현재 위치를 기준으로 상대적 거리르 계산해서

반응형